Más Información

Coche bomba fue accionado a distancia: fiscal de Michoacán; probables responsables están ubicados, dice

A tres años del caso Ciro Gómez Leyva ¿qué es lo que ha pasado?; aquí una cronología, detenidos y sentencias

"Maduro es dictador, pero no es narcotraficante", dice Gustavo Petro; esa es una narrativa de EU, acusa

VIDEO Brugada encabeza encendido navideño en Zócalo de CDMX; "Construimos alegría y convivencia en este hermoso lugar", dice

Así cubrieron medios internacionales la pelea en el Congreso de la CDMX; "se convirtió en un ring de la WWE"

Chocan Rojo de la Vega y Fernández Noroña por pensión del bienestar; “¿le alcanzó para comprar su casa millonaria de Tepoztlán?”

EU y México alinean estrategias de seguridad; impulsan intercambio de datos para frenar huachicol y drones fronterizos

¿Qué acordaron México y EU en la segunda reunión de Seguridad?; armas, huachicol y extradiciones los temas claves

Dan 14 años de cárcel a "El Patrón", autor intelectual del atentado contra Ciro Gómez Leyva; asegura recibió órdenes del CJNG

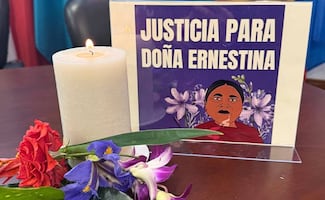

México reitera que acepta responsabilidad en el caso de Ernestina Ascencio; analizará razonamientos de la Corte Interamericana

La tecnológica OpenAI, matriz de ChatGPT, anunció que lanzará controles parentales en su conocido chatbot después de que hayan aumentado las acusaciones de padres apuntando a que el famoso asistente de inteligencia artificial (IA) contribuyó a las autolesiones o al suicidio de sus hijos.

"Estos pasos son solo el comienzo (...) Seguiremos aprendiendo y reforzando nuestro enfoque, guiados por expertos, con el objetivo de que ChatGPT sea lo más útil posible", detalló la empresa en un comunicado sin vincular la nueva implementación con las demandas que ha recibido.

Entre otras, la de los padres de un joven de 16 años que se quitó la vida tras meses de interactuar con ChatGPT y quienes se querellaron en California contra OpenAI y su dueño, Sam Altman, argumentando que el chatbot, bajo el modelo GPT-4o, no aplicó medidas de seguridad pese a quedar claras las intenciones suicidas del joven.

ChatGPT comete fallos en casos "sensibles", admite OpenAI

La empresa aceptó entonces que su asistente de IA comete fallos en casos "sensibles" y prometió cambios tras recibir la demanda.

Las medidas anunciadas hoy, que se aplicarán desde el próximo mes pero sin fecha exacta aún, permitirán a los progenitores vincular su cuenta con las de sus hijos -pudiendo revisar cómo responde ChatGPT a sus peticiones- y que, entre otras funciones, reciban una notificación cuando el sistema detecte que los menores están pasando por algún problema de inestabilidad emocional aparentemente preocupante.

Además, OpenAI, que ha sido ampliamente criticada porque el modelo GPT-5 era excesivamente halagador y poco crítico, dijo que dirigirá las conversaciones con signos de "estrés agudo" a un modelo del mencionado ChatGPT especializado en razonamientos provisto por directrices de seguridad más específicas y estrictas.

Lee también ChatGPT5: OpenAI su modelo más avanzado de IA; ¿cuándo estará disponible y cuáles serán sus funciones?

En julio, senadores estadounidenses escribieron una carta a la compañía exigiendo información sobre sus iniciativas para prevenir las autolesiones y el suicidio, después de constatarse registros de respuestas delirantes en situaciones límite.

El grupo de defensa Common Sense Media declaró en abril que los adolescentes menores de 18 años no deberían poder usar aplicaciones conversacionales de IA porque representan "riesgos inaceptables".

Y es que también ha aumentado la preocupación por el apego emocional que los usuarios generan con ChatGPT, lo que en algunos casos resulta en episodios de dependencia y aislamiento familiar.

Señales de aviso y cómo prevenir el suicidio

El suicidio es un problema de salud mental muy complejo. Hablar de querer morirse es una conducta que debe tomarse en serio y ofrecer ayuda a quien lo manifieste. Otras señales de alerta son:

• Hablar de sentir que no hay esperanza o que no hay razón de vivir

• Hablar de sentirse atrapado o tener un dolor insoportable

• Hablar de ser una carga para otras personas

• Aumentar el uso del alcohol o las drogas

• Actuar de manera ansiosa, agitada o peligrosa

• Dormir muy poco o demasiado

• Aislarse o sentirse aislado

• Exhibir ira o hablar de vengarse

• Exhibir extremos de temperamento

• Exhibir extremos de temperamento

Si detectas alguna de estas o varias señales no dejes sola a esa persona, pide ayuda a un especialista médico, psicólogo, tanatólogo o terapeuta. Retira cualquier arma, sustancias, alcohol, drogas, o los objetos afilados que pudieran utilizarse en un intento de suicidio.

En caso de emergencia, una opción de ayuda puede ser la Línea de la Vida, disponibles en redes sociales como @LaLineaDeLaVidamx y @LineaDe_LaVida, así como vía telefónica 800 911 2000.

sg/mcc

Más Información

Noticias según tus intereses

ViveUSA

[Publicidad]